اجماع گستردهای وجود دارد که «DeepSeek» با ابداع یک مدل زبانی پیشرفته که با توان محاسباتی کمتری کار میکند، انقلابی در عرصه هوش مصنوعی به پا کرده است. با این حال، اینکه آیا افزایش راندمان هوش مصنوعی، نیاز به مس در مراکز داده را کاهش میدهد یا خیر، همچنان محل مناقشه است.

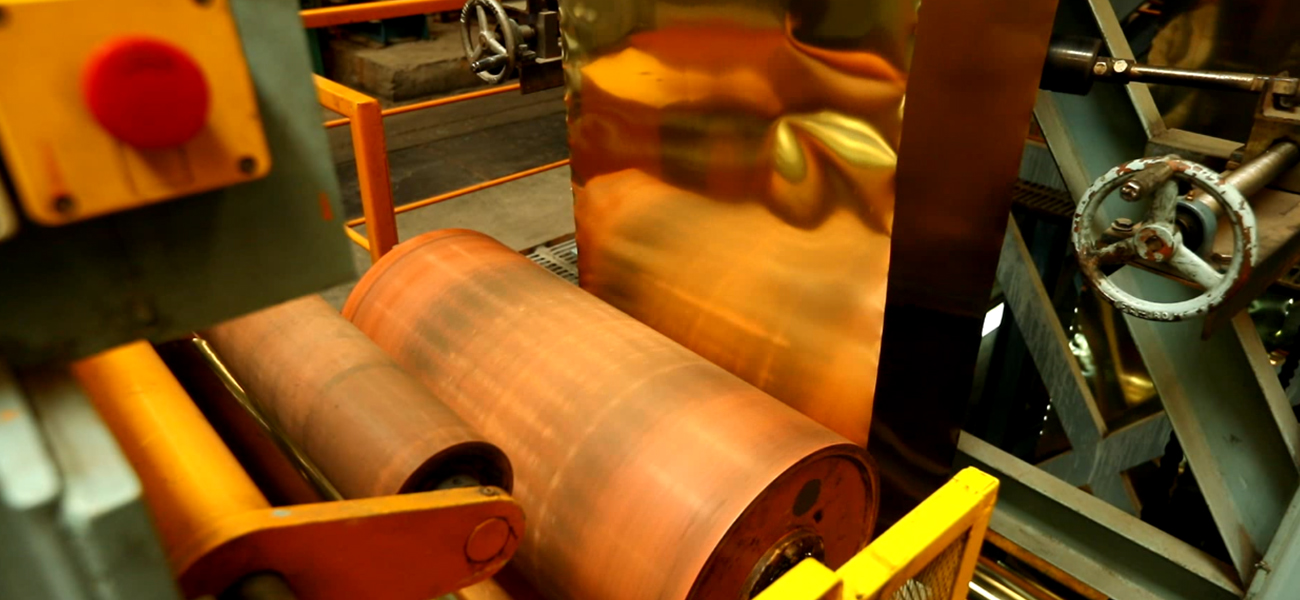

به گزارش پایگاه خبری و تحلیلی «فلزاتآنلاین» و به نقل از موسسه «Fastmarkets»، مراکز داده مراکزی هستند که سرورهای رایانهای در آنها دادههای کلان را گردآوری، ذخیره و پردازش میکنند. طی چند سال اخیر، صنعت مس با علاقه روزافزونی به این مراکز به عنوان عاملی نوظهور در افزایش تقاضای فلز سرخ نگریسته است.

دلیل این امر آن است که مس در زیرساختهای گسترده شبکه برق و تامین انرژی مورد نیاز مراکز داده به کار میرود. این فلز در کابلهای برق، شینهها، اتصالات الکتریکی و نوارهای توزیع برق یافت میشود و همچنین به عنوان رسانای حرارتی در مبدلهای حرارتی مورد استفاده قرار میگیرد که برای خنکسازی سرورها ضروری هستند.

به همین دلیل، میزان مس مصرفی در مراکز داده چشمگیر و قابل توجه است. در سال ۲۰۰۹، تحلیلگران صنعت برآورد کردند که شرکت مایکروسافت برای احداث مرکز داده ۵۰۰ میلیون دلاری خود در ایالت شیکاگو، حدود دو هزار و ۱۷۷ تن مس مصرف کرده است (معادل ۲۷ تن به ازای هر مگاوات توان مصرفی).

با توجه به افزایش تعداد مراکز داده در سراسر جهان و نیاز فزاینده سرورهای سازگار با هوش مصنوعی به برق، میزان مصرف مس رو به افزایش است.

گزارش اخیر شرکت «Macquarie» برآورد میکند که تا سال ۲۰۳۰، میزان مصرف مس در مراکز داده بین ۳۳۰ هزار تا ۴۲۰ هزار تن خواهد بود (میانگین ۳۷۵ هزار تن). این شرکت خاطرنشان کرد که این برآورد، برنامههای اعلام شده از سوی شرکتهای مایکروسافت و متا در ماه ژانویه ۲۰۲۵ و همچنین پروژه عظیم ۵۰۰ میلیارد دلاری «Stargate» برای توسعه زیرساختهای «OpenAI» در ایالات متحده آمریکا را در نظر گرفته است.

این برآورد همچنین بر پایه پیشبینی افزایش ظرفیت برق مورد نیاز از ۷۷ گیگاوات در سال ۲۰۲۳ به ۳۳۴ گیگاوات در سال ۲۰۳۰ محاسبه شده است. برآورد مذکور، استفاده مداوم از مس برای انتقال داده در مراکز داده را نیز در نظر میگیرد؛ هرچند که فیبر نوری اکنون انتخاب ارجحتری برای اتصال محسوب میشود. با این حال، این محاسبات شامل پروژه جدید «DeepSeek World» نمیشود و همین مسئله نقطه آغاز بحثهای مربوط به مس است.

در این میان، دو پرسش مطرح است؛ آیا هوش مصنوعی «DeepSeek» واقعا همانطور که ادعا میشود، به میزان کمتری توان محاسباتی برای اجرا نیاز دارد؟ و یا قابلیتهای زنجیره تفکر و استدلال آن برای مرحله استنتاج (مرحلهای که در آن نتیجهگیریهای نهایی انجام میشود)، به توان محاسباتی بیشتری نیاز دارد؟

به عبارت دیگر، آیا «DeepSeek» نسخهای کمهزینه از هوش مصنوعی است که هرچند فرایند آموزش آن کارآمدتر است اما در مرحله استنتاج چندان بهینه عمل نمیکند؟

اگر از جمله شرکتهای غربی فعال در حوزه فناوری باشید که در زمینه توسعه هوش مصنوعی فعالیت دارند، به احتمال زیاد در گروه حامیان این دیدگاه قرار میگیرید. علاوهبراین، احتمالا معتقدید که کارایی بیشتر در هوش مصنوعی، لزوما به کاهش نیاز به توان محاسباتی (و در نتیجه مصرف کمتر مس) منجر نمیشود.

هفته گذشته، زمانی که موضوع «DeepSeek» مطرح شد، ساتیا نادلا، مدیرعامل شرکت مایکروسافت دقیقا همین موضعگیری را داشت.

وی به نظریه پارادوکس جونز استناد کرد؛ نظریهای که میگوید پیشرفت فناوری، با وجود کاهش هزینه یا افزایش بهرهوری یک منبع، اغلب باعث رشد تقاضای آن میشود.

نادلا در پایان خاطرنشان کرد: با کارآمدتر و در دسترستر شدن هوش مصنوعی، شاهد افزایش سرسامآور استفاده از آن خواهیم بود؛ تا جایی که به یک منبع ضروری تبدیل میشود که هیچگاه از آن سیر نخواهیم شد.

انتهای پیام//